Корпоративный мир принимает контрастный душ. На уровне стратегии — горячо: компании наперебой заявляют о внедрении ИИ, это стало маркером прогрессивности. На уровне операционки — лед: многие сотрудники используют ИИ втихую, с чувством вины. Все потому, что обращаться к генеративным технологиям до сих пор синонимично читерству, а читерство, видите ли, не для профессионалов. Консультант по нейросетям Наиля Аглицкая разбирает, как работает ИИ-шейминг и почему культура двойных стандартов приводит к реальным убыткам.

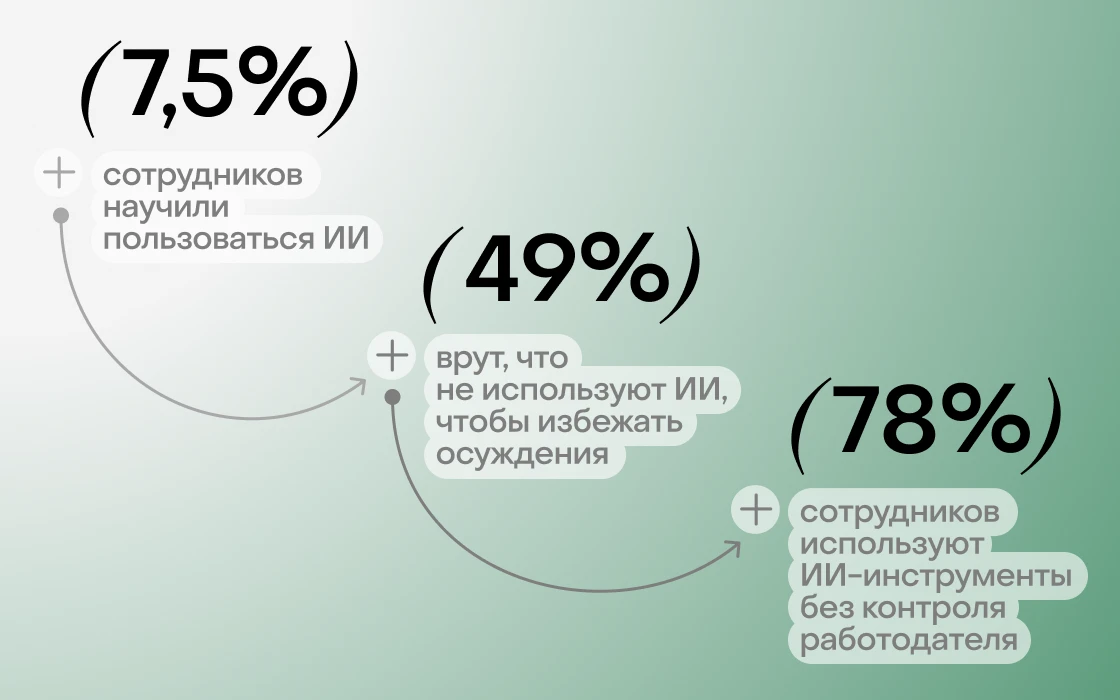

Цифры рисуют картину организационной шизофрении: бизнес активно интересуется и экспериментирует с генеративным ИИ, но только у каждой восьмой фирмы есть внятная стратегия с разнообразными сценариями, не говоря уже о передаче команде необходимых навыков, инструкций и сервисов. В США, например, полноценное обучение прошли не больше 8% сотрудников, 23% не обучались вовсе, а половина работников существуют в противоречивых протоколах относительно того, когда и как использовать нейросети.

В этом вакууме расцветает теневая эксплуатация. Почти 80% людей работают с несанкционированными ИИ-инструментами, без контроля работодателя за чувствительными данными и тем более за качеством выдачи, выяснила WalkMe, опросив 1 тыс. специалистов из США, пользующихся ИИ.

{{slider-gallery}}

В общем, компании похожи на родителей, которые разрешают ребенку брать велосипед, но не учат кататься, да и шлем не купили. Результат предсказуем: коллектив осваивает технологию методом тыка, ошибки при этом прячутся, удачи не масштабируются. Знания передаются из уст в уста, как народные рецепты от простуды: «Наш маркетолог с Midjourney магию творит — сходи, спроси», «А вчера продакт за полчаса презентацию сделал: говорят, какой-то промпт волшебный знает». Больше похоже на сарафанное радио, чем на корпоративную базу знаний.

Что самое печальное, половина работников, в том числе топ-менеджеры, скрывают применение ИИ, боясь осуждения, видно из того же опроса WalkMe. Зумеры вообще возвели такую маскировку в ранг искусства: шесть из десяти молодых сотрудников, использующих ИИ, выдают работу моделей за собственную, еще 55% кивают на встречах, делая вид, что разбираются в ИИ лучше, чем есть на самом деле. Так выглядит адаптация к среде, где одновременно требуют быть AI-native, но наказывают за слишком заметную автоматизацию.

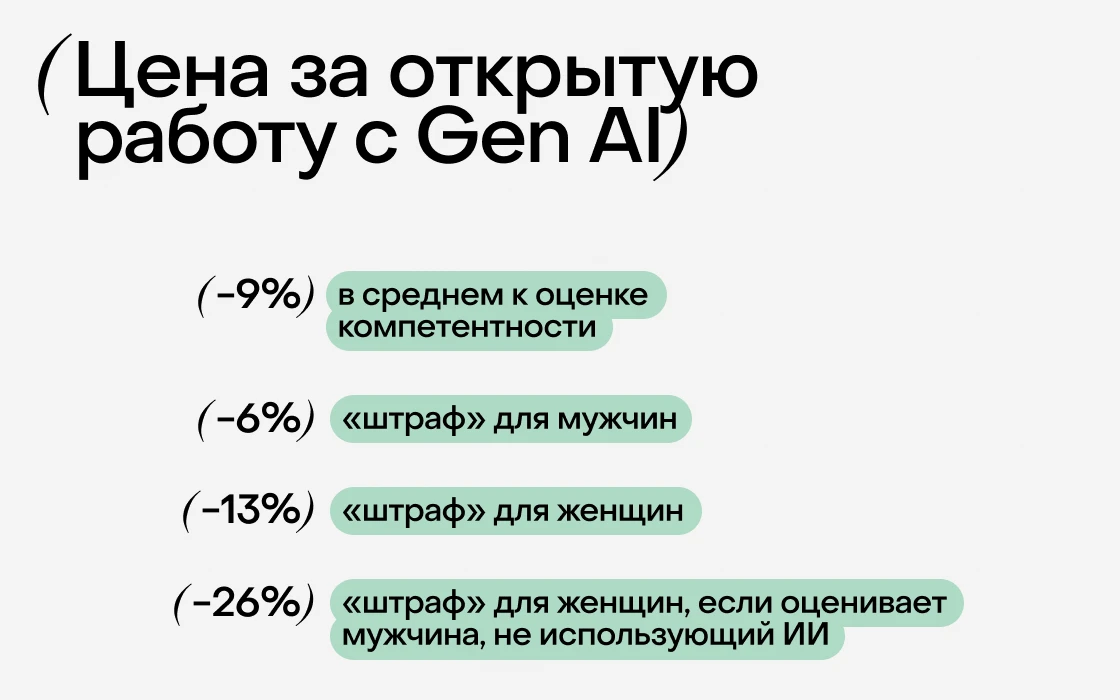

Дальше — больше. Исследователи из Пекинского и Гонконгского политехнического университетов обнаружили токсичный эффект: компетентность программистов, открыто использующих ИИ, оценивают в среднем на 9% хуже, чем компетентность их коллег, публично избегающих ИИ, несмотря на идентичное качество работы. Дискриминация по ИИ-признаку усугубляется сексизмом: для женщин этот «штраф» существенно выше — около 13%, в то время как для мужчин — около 6%. Особенно заметны перекосы со стороны мужчин-рецензентов, не пользующихся нейросетями: они оценивают женщин — адептов ИИ на 26% хуже.

Выводы ученых обнажают парадокс: технологии, призванные повышать продуктивность, могут ослаблять пользователей, подрывать их статус — это тормозит общий прогресс и закрепляет неравенство.

{{slider-gallery}}

Цена всей этой предвзятости может быть очень высокой. Взять недавний позор Deloitte в Австралии: фирме из «большой четверки» придется вернуть хотя бы часть из $290 тыс. — именно столько выложило местное правительство за отчет с «галлюцинациями» вроде фейковых цитат и десятками вымышленных ссылок. Вряд ли бы это случилось, имей компания прозрачную культуру использования нейросетей и гайдлайны, где четко написано: «Всегда перепроверяй то, что сгенерировал ИИ».

Все мы росли в парадигме, где ценность работника равна времени, умноженному на усилия. Генеративный ИИ сломал это уравнение: теперь можно сделать за час то, на что раньше уходил день. Но культурный код не перезаписался — использование нейросетей пока чаще трактуется как уловка, а не как передовая практика, особенно в индустриях с культом персональной экспертизы: в консалтинге, праве, медицине.

Сама фраза «Это что, ChatGPT писал?» превратилась в удобный ярлык, стала новым способом обесценить чужой труд, намекнув на его механистичность. В такой логике истинность «ИИ-следа» вторична, рассуждает исследователь из Microsoft, преподающий в Кембридже, — обвинение работает как оружие в офисной политике, даже если нет доказательств.

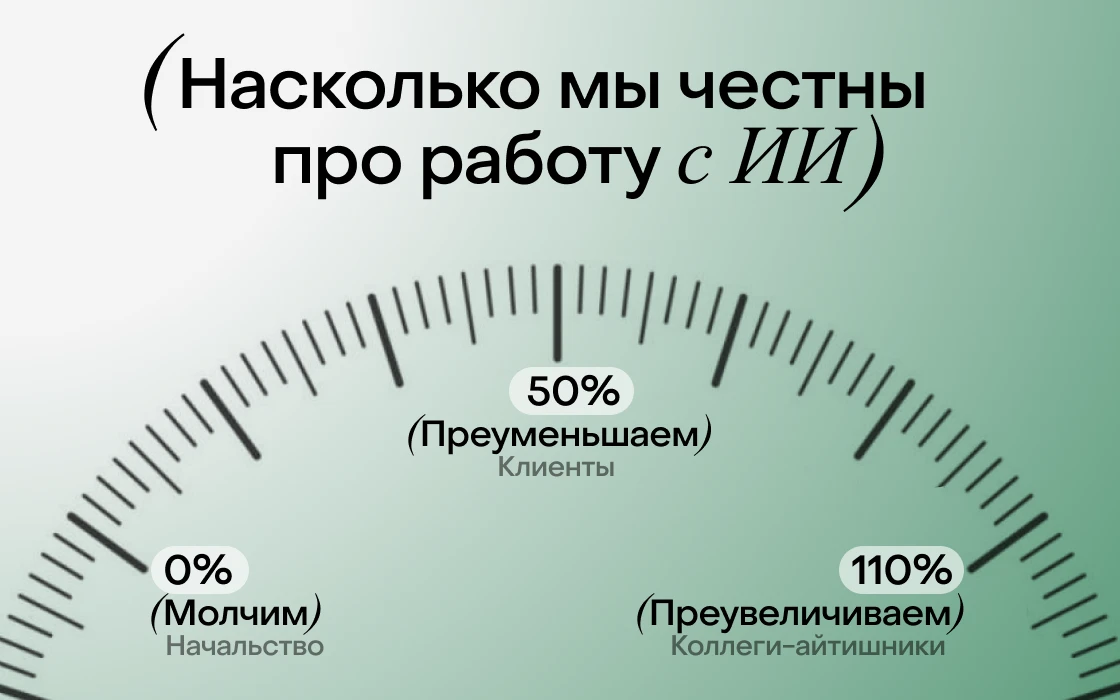

В ответ адептам ИИ приходится жонглировать правдой в зависимости от собеседника: с технически подкованными коллегами — преувеличивать использование и понимание нейросетей (надо же выглядеть прогрессивным); с клиентами — преуменьшать (те платят за авторский труд, зачем их расстраивать?); с начальством — вообще лучше молчать (вдруг решат, что можно сократить, раз машина справляется).

{{slider-gallery}}

В общем, в основе маневрирования лежит вполне понятный экзистенциальный страх остаться за бортом. Логика кажется железной, и в то же время она противоречива: с одной стороны, давит мысль «Если машина делает половину моей работы, моя ценность тоже половинчатая»; с другой — преследует ощущение «Я отстану, если не буду использовать технологии». Эта тревога не обходит и руководителей: 54% топ-менеджеров чувствуют себя самозванцами в контексте внедрения ИИ — на это указывал EY еще в прошлом году.

Абсурд достигает пика, когда люди начинают бояться порицания за то, чего не делали, — переживать, что их работу примут за машинную, даже если они вообще не открывали диалог с чат-ботом. И сами с подозрением смотрят на ИИ-вотермарки, задуманные для защиты авторства и прозрачности. Так, семь из десяти пользователей ChatGPT считают, что практика детектирования ИИ-следа приведет к ложным обвинениям в «искусственности» работы. И почти треть сказали, что станут реже пользоваться этим сервисом, если он внедрит водяные знаки, а конкуренты — нет. Поэтому пока OpenAI не помечает сгенерированный контент, хотя у нее уже давно есть возможности для этого, выяснил The Wall Street Journal еще в прошлом году.

Остается процитировать того же исследователя из Microsoft: «Пользователи явно ценят возможность применять ChatGPT незаметно. И без культуры шейминга такого возвеличивания скрытности не возникло бы».

Прятать работу с ИИ — это не ложь в чистом виде, скорее социальная навигация, которая все же порождает серьезную проблему: когда все играют в эту игру, никто не видит реальной картины. Начальство не понимает, как именно работает команда. Команда не осознает, что можно, а что нельзя. Клиенты живут в иллюзии, что им все делают вручную. И все притворяются, что так и надо, что мир еще не изменился.

К принятию ИИ редко приходят прямой дорогой: обычно наблюдаются довольно долгие колебания между личными убеждениями и внешним контекстом. Ниже — четыре узнаваемых состояния.

Динамика движения по этим уровням необязательно линейная и односторонняя. Один и тот же специалист может спокойно обсуждать ИИ-галлюцинации с продуктовой командой и полностью обходить тему на звонке с консервативным клиентом. Или быть евангелистом Midjourney, но категорическим противником ИИ-копирайтинга. В общем, одобрение контекстно, и именно поэтому бизнесу нужна не столько конкретная позиция, сколько пространство, в котором использовать технологии безопасно и нестыдно.

{{slider-gallery}}

Скорость и траектория адаптации той или иной команды к реальности, где от ИИ уже не отвертеться, зависят от трех факторов: цены ошибки, поведения лидеров и инфраструктуры знаний.

Первое и ключевое — что с вами будет, если честно скажете: «Попробовал, не получилось»? Если приучать к ИИ угрозами: «Не освоите — уволим», возникнет обратный эффект — паралич вместо экспериментов, имитация вместо инноваций. Да, первые диалоги с ботами почти неизбежно разочаровывающие, но это часть обучения, а не признак некомпетентности. Задача руководства и более прошаренных коллег тут — не загонять новичков в угол стыдом и страхом, а дать простор для проб и ошибок, из которых и вырастут реальные скиллы. Например, можно завести ритуал разбора неудач: публично делиться тем, что не получилось и что из этого узнали.

Второй вопрос — что делают те, на кого смотрят? Если руководитель на словах ратует за прогресс, а сам отрицает, что сгенерировал презентацию, сигнал считывается мгновенно. Все-таки культура в компании формируется по реальным поступкам, а не корпоративным манифестам.

И третье: есть ли хоть какие-то инструменты и способы делиться находками? Работа с ИИ принципиально отличается от классических офисных навыков: научился пользоваться CRM или сканировать документы — этого хватит на годы. Нейросети же меняются ежемесячно, так что культура их использования должна быть настроена на постоянное обновление. Так, можно делать дайджесты новостей, апдейтить инструкции, экспериментировать с сервисами и поддерживать инициативы снизу — например, в формате мини-хакатонов, где каждый желающий может потренироваться в безопасной среде.

Венчает это все культура ответственности за результат, и это касается не только работы с ИИ. История Deloitte хорошо иллюстрирует, что происходит, когда этой культуры нет: никто не берет на себя ответственность проверить, не чушь ли получилась в итоге. ИИ-шейминг играет тут большую (и плохую) роль: лишает команду естественной страховки, когда коллега может спросить: «А ты ссылки-то проверил?» — и это не воспринимается как обесценивание.

Если совсем кратко, нужно задаваться не вопросом «Использовать ли ИИ?», деля мир на черное и белое. Куда эффективнее обсудить, для чего именно использовать ИИ: где генерация действительно расширит горизонты, а где просто позволит поскорее закрыть горящие задачи.

Это не революция и не сиюминутая трансформация — скорее постепенное размораживание. И кстати, компании, где этот процесс уже идет, необязательно самые технологичные или прогрессивные, просто там нашелся кто-то — фаундер, тимлид, авторитетный коллега, — кто не побоялся первым выйти из тени. Остальные продолжат играть в прятки, пока и в их команде кто-нибудь не включит свет. Ну или пока не получат счет, совсем как Deloitte.