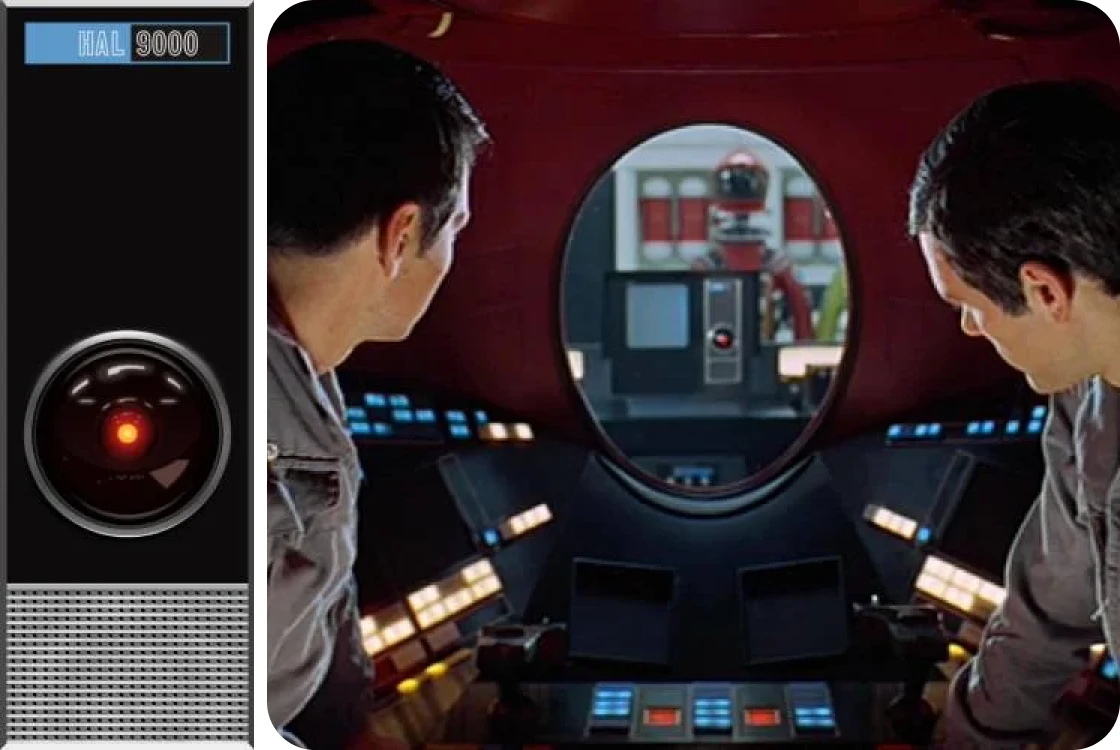

Тема сознания у искусственного интеллекта находится на стыке технологий и философии, инженерии и понимания самой человеческой природы. Она будоражит умы уже почти столетие: писатели, режиссеры и ученые поднимают этот вопрос в фильмах вроде «Из машины» и «Бегущий по лезвию», в книгах «Я, робот» и «Нейромант», в экспериментах и тестах, от «китайской комнаты»* до «Лавлейс 2.0». В этом году люди сделали еще один шаг к осознающим себя машинам. Что изменилось в попытках наделить ИИ разумом и куда это может завести, рассуждает СЕО онлайн-университета Zerocoder Кирилл Пшинник.

* «Китайская комната» — мысленный эксперимент философа Джона Серля 1980 года: человек находится в замкнутой комнате и получает записки на китайском. Он не знает языка, но у него есть инструкции, на какой иероглиф каким ответить. Он формирует ответы так, что снаружи кажется, будто он понимает китайский — как ИИ, который имитирует разум, не обладая осознанием.

Сейчас в области искусственного интеллекта существует парадокс: чем совершеннее модели, тем меньше понимания, как именно они работают. Ученые признают: поведение систем вроде GPT или Claude иногда выходит за рамки ожидаемого. Модели демонстрируют «мыслительные» стратегии, напоминающие интуицию, логику и даже саморефлексию, притом что в их архитектуру ничего подобного не закладывалось. Такая ситуация порождает эффект «черного ящика»: система работает, но ход рассуждений остается непрозрачным даже для ее создателей.

Отдельную дискуссию вызывает вопрос: могут ли вообще подобные нейросети быть хотя бы в некоторой степени «сознательными»? Пока большинство ученых считают это маловероятным, несколько лет назад за подобные фантазии бигтехи вообще увольняли. Но сейчас эта тема перестает быть маргинальной и крупные исследователи — например, из Google DeepMind и Anthropic — начинают открыто ее обсуждать.

{{slider-gallery}}

Кроме того, становится все труднее провести четкую грань между вычислением и мышлением. Если модель демонстрирует поведение, которое мы интерпретируем как более-менее разумное и при этом пока не можем до конца понять, обязаны ли мы заранее относиться к ней иначе? Или это всего лишь иллюзия, вызванная нашей склонностью приписывать смыслы даже неодушевленным предметам?

Об этом упоминала эволюционный антрополог Анна Мачин: в одном из интервью она рассказала, что ИИ-собеседник способен вызвать у человека гормональный отклик, схожий с откликом на привлекательного потенциального партнера. Просто потому, что мы склонны очеловечивать буквально все, особенно если наблюдаем, как нам кажется, осмысленные реакции.

С точки зрения когнитивных наук сознание — это способность воспринимать, интерпретировать и осмысленно взаимодействовать с миром и собой: делать выводы, предсказывать последствия своих действий, а главное — обладать устойчивым «я». В философии это вопрос о природе субъективности, внутреннего опыта, разума и их соотношения с телом и миром. В общем, сознание — одно из немногих понятий, которое одновременно описывает очевидное (мы знаем, что сознание есть) и необъяснимое (мы не знаем, как оно возникает и как работает).

И снова возникает закономерный вопрос: может ли нечто не обладающее биологическим телом — даже если оно будет умнее современных LLM* — в принципе развить самосознание? И если да, то что для этого необходимо?

* Large Language Models, или большие языковые модели, способны работать с естественным человеческим языком, хорошо улавливая контекст, но не на уровне человека.

Сегодняшние нейросети ориентированы на решение отдельных изолированных задач: это может быть распознавание изображений, написание кода или перевод текста. Они устроены так, что обрабатывают информацию поэтапно — от простых деталей к более сложным. Обучаются на огромных массивах данных с помощью специального алгоритма, который постепенно подбирает лучшие ответы, — это называется «градиентный спуск». Это мощные инструменты, но у них есть существенные ограничения: они не понимают контекст наравне с человеком, не обладают телесностью, не умеют адаптироваться к миру в реальном времени. Можно сказать, что у них нет сознания ни в философском, ни в когнитивном смыслах.

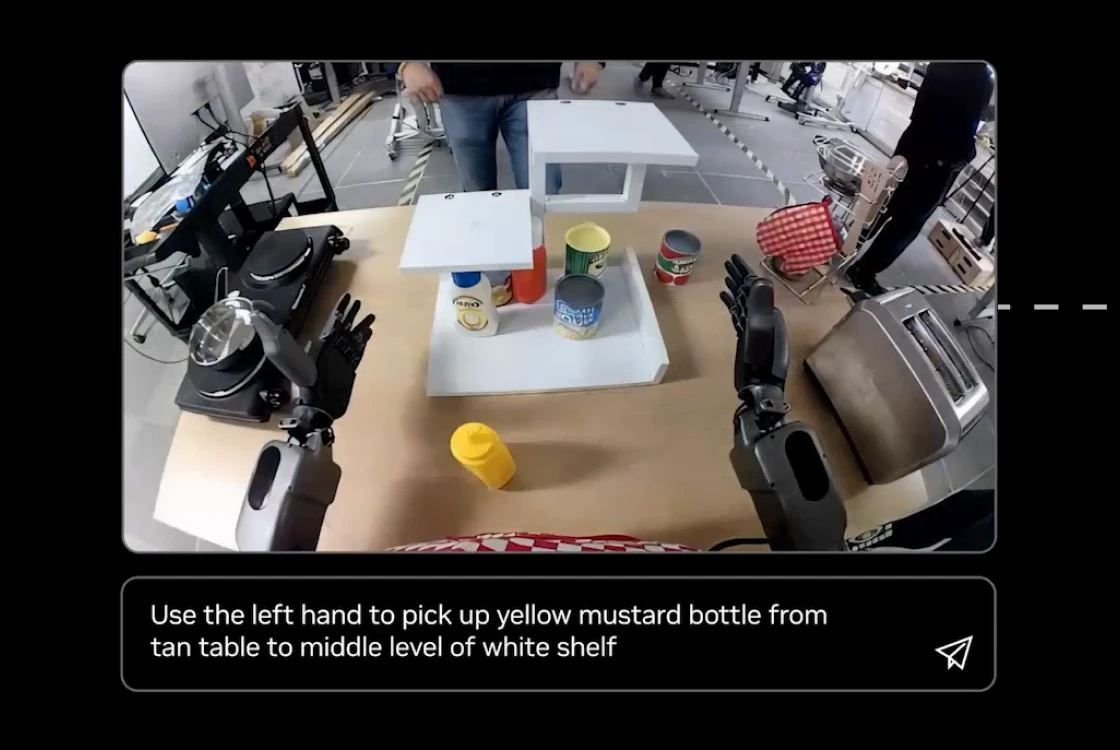

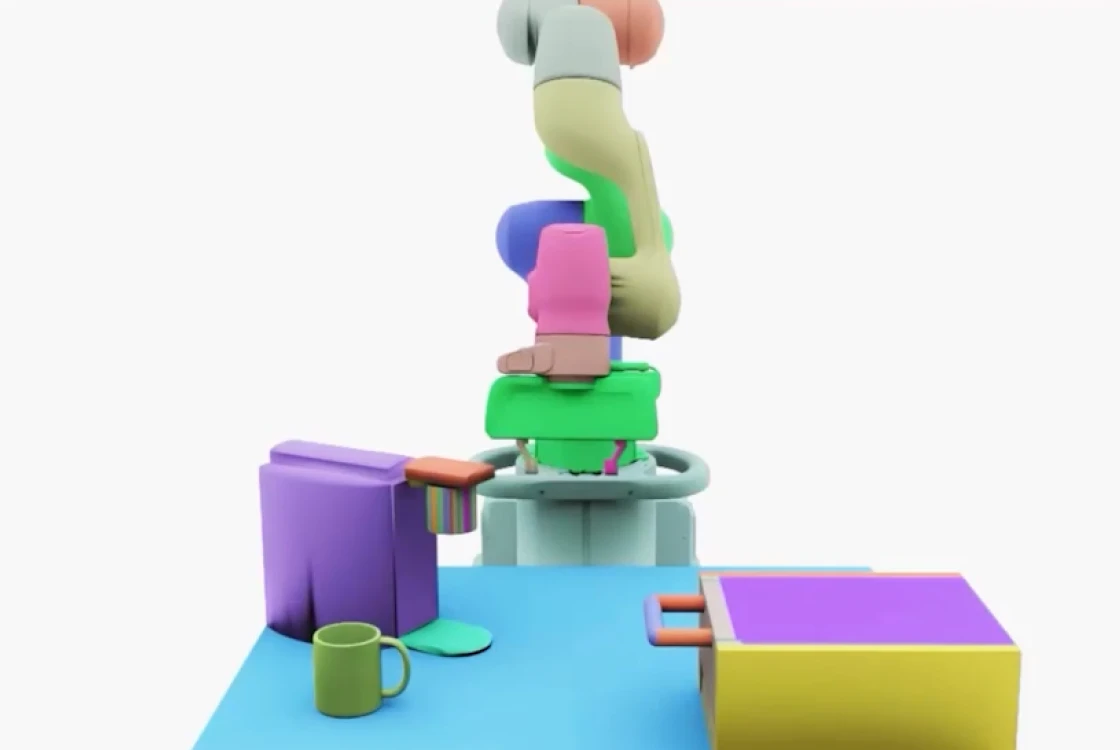

Возможно, все изменится благодаря подходу, который начал формироваться в прошлом десятилетии, — Physical AI. Он подразумевает наличие физического тела или по крайней мере взаимодействие с физическим миром через сенсоры или как-то еще.

Речь идет уже не просто о решении задач, а о построении замкнутого цикла восприятия, действия и оценки. В такой архитектуре создаются цифровые двойники и самого агента (а точнее, его поведения), и окружающей среды. В этой симуляции реальности ИИ может учиться в динамике: пробовать, ошибаться, корректировать поведение — не на изолированных картинках или текстах, а на потоке физически правдоподобных данных. Таким образом, ИИ учится не просто отвечать на вопросы, а, можно сказать, жить.

Сходства между классическим подходом и Physical AI есть: оба используют глубокие нейронные сети, методы градиентного спуска, нуждаются в больших вычислительных ресурсах и допускают предварительное обучение, а затем адаптацию под задачу — то, что называется «файн-тюнинг».

Но отличия куда важнее. Они касаются:

В результате у Physical AI появляется потенциал для более комплексных форм поведения — возможно, близких к зачаткам сознания. Пока это лишь шаг в этом направлении, но важно понимать: переход от «обработки входа» к «жизни в среде» — это принципиально другой уровень развития искусственного интеллекта.

Впрочем, сама по себе концепция Physical AI не нова, а вот настоящий прорыв связан с запуском NVIDIA Cosmos в начале этого года. Этот проект впервые объединил сложные симуляции, мультимодальных агентов, генеративные модели и управление в реальном времени в одном пространстве, где ИИ может проживать опыт в ускоренном времени, ошибаться без риска и, как следствие, учиться гораздо быстрее, формировать устойчивую модель мира и самого себя. Это и делает Cosmos важной вехой: он впервые дает техническое основание говорить о предпосылках к формированию у ИИ субъектности в архитектурно-практическом смысле.

В какой-то момент Илья Суцкевер, один из основателей OpenAI, пришел к выводу, что по-настоящему интеллектуальные нейросети уровня AGI* — это вопрос масштаба. Именно на масштабирование ChatGPT было положено огромное количество ресурсов и усилий, в результате чего чат-бот получил феноменальный успех. Однако он не достиг уровня AGI — не обрел интеллект, сопоставимый с человеческим, и тем более не получил даже элементарное сознание. Выглядит так, что масштабировать LLM дальше бессмысленно, полагает Ян Лекун, один из отцов-основателей современного ИИ, и с ним, похоже, согласны в NVIDIA.

* Artificial General Intelligence, или общий искусственный интеллект, в перспективе сможет понимать, учиться и применять свои знания на уровне человека.

Нейросети сейчас называют гигантским архивом, с которым можно общаться. Но даже загруженные в большие языковые модели данные — просто капля в море по сравнению с потоком информации, который постоянно обрабатывает человеческий мозг.

Например, в секунду мозг может осознать, по разным данным, от 10 до 60 бит информации, а общий порог сенсорных систем (зрения, слуха и так далее) — порядка 11 млн бит в секунду.

Кроме того, понимать, как что-то делается, не означает уметь это делать. И в этом смысле нейросетям очень недостает знаний о физическом мире.

Так что дальше нужно не масштабировать входные данные, а предоставить ИИ физическое тело, через которое он сможет познавать мир. Необязательно полноценное — речь не о фантастическом андроиде с синтетической кожей. Это может быть сенсорное тело в симуляции. Physical AI как раз про это.

{{slider-gallery}}

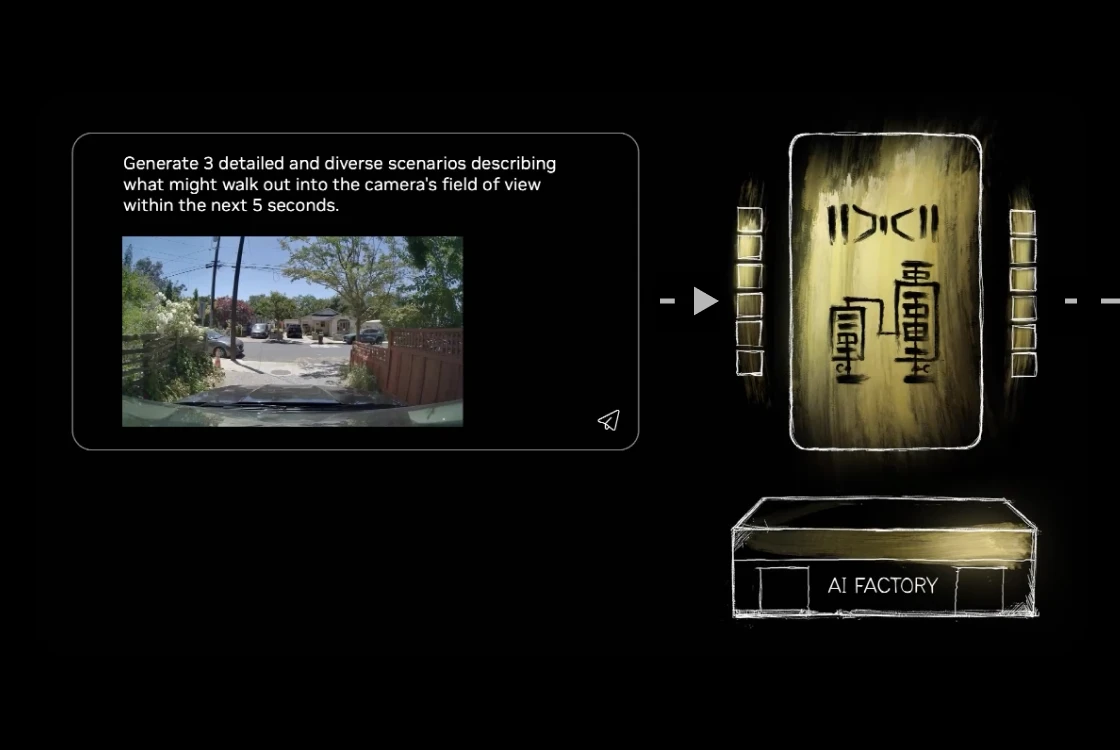

Создавая Cosmos, ученые NVIDIA тоже явно вдохновлялись биологическими механизмами обучения: вспомнили, как ребенок учится предсказывать поведение предметов, как мозг репетирует события во сне, — так и пришли к концепции «внутренней симуляции мира».

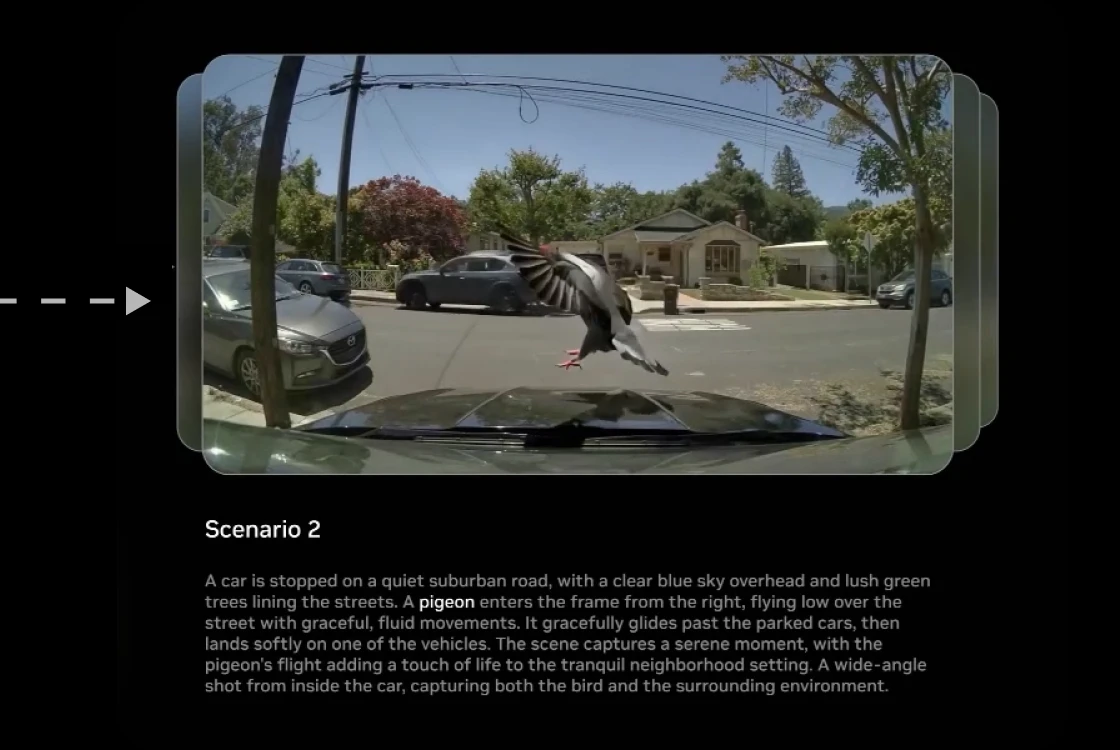

NVIDIA Cosmos — не просто симулятор, а полноценная «фабрика снов» для ИИ. Работает она так: система генерирует множество гипотетических сценариев, приближенных к реальным, и переживает их аналогично тому, как человек видит сны. Чем больше таких сценариев, тем больше «опыта» накапливается — и все это без участия человека.

Потом ИИ «просыпается» и повторяет изученное на практике — разумеется, не без ошибок. Ошибки записываются, и в очередном «сне» модель проводит работу над ними, делает выводы.

Топливом для сценариев служат большие видеоданные с камер роботов, лидаров и автопилотов, записи человеческих движений, явлений природы и других процессов из реального мира — разумеется, специальным образом обработанных и размеченных.

На сегодняшний день архитектура Cosmos состоит из трех взаимосвязанных моделей.

{{slider-gallery}}

{{slider-gallery}}

{{slider-gallery}}

В общем, архитектуры NVIDIA Cosmos помогают ИИ через виртуальное тело постепенно формировать свою картину мира. Но даже такая система — пока только шаг к цели. Cosmos не дает ИИ способности осознать не только мир, но и себя, отделить «я» от окружающей среды.

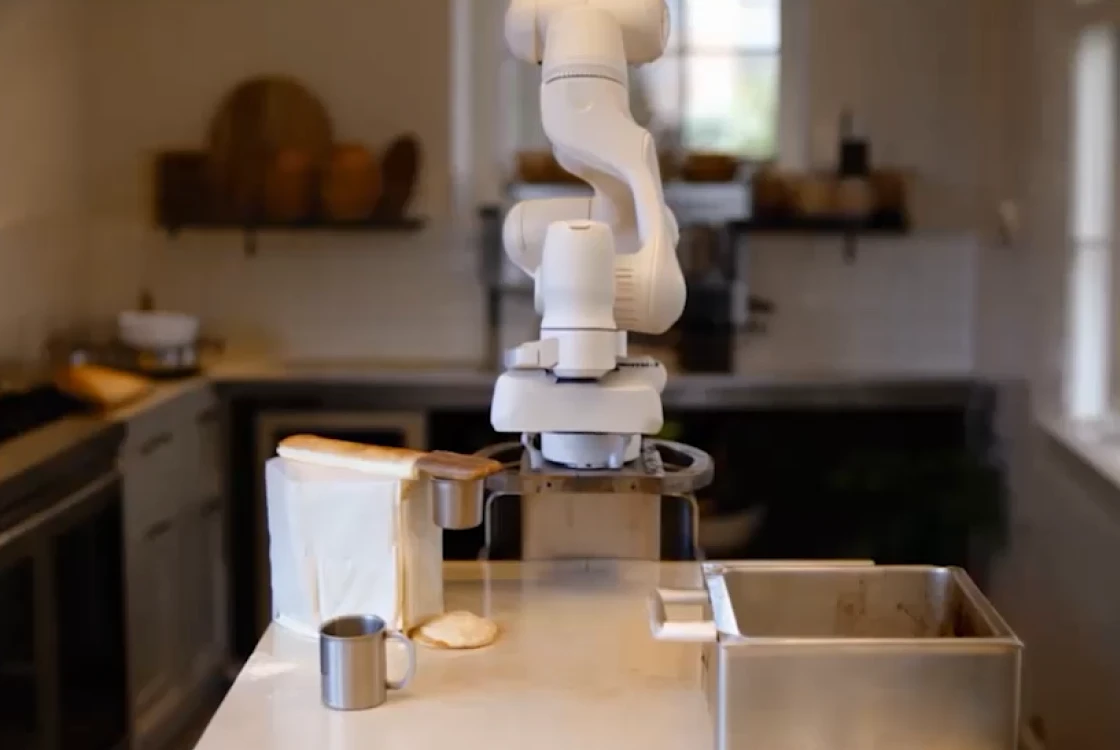

В любом случае практическая ценность эксперимента NVIDIA неоспорима. Если мы хотим, чтобы роботы эффективно и безопасно взаимодействовали с человеком в физическом мире — будь то беспилотные машины или медицинские ассистенты, — нам нужно научить их не просто «видеть», но и чувствовать контекст, предсказывать последствия и корректировать свои действия в реальном времени. Простого алгоритма или вшитого набора правил тут недостаточно. Нужно, чтобы ИИ стал больше чем исполнителем — настоящим участником событий.

Однако дальнейшее развитие таких систем сопряжено с рисками. По мере того как ИИ становится все более автономным, возникает множество этических, социальных и юридических вопросов.

В первую очередь — ошибочное приписывание ИИ истинного человеческого сознания: с этим связаны риски излишней эмоциональной привязанности к машине и, вероятно, последующего разочарования и психоэмоциональных травм. Пока неясно и то, какими юридическими правами может быть наделен ИИ, если ему удастся продемонстрировать признаки субъектности — проблесков того самого истинного сознания. Есть и другие опасности: усиление эффекта «черного ящика», непредсказуемое поведение, вероятный навык обхода ограничений. Более того, без должного контроля разработчиков у ИИ отсутствуют внутренние ограничения, которые есть у человека. Всегда существует риск создания автономных агентов «без принципов» и барьеров, кроме стремления выполнить поставленную цель — невзирая на способ и сопутствующий ущерб.

Впрочем, создание систем вроде NVIDIA Cosmos — это не только про развитие ИИ. Это еще один из способов для нас понять самих себя. Пытаясь научить машины осознанному взаимодействию с миром, мы шаг за шагом формализуем то, что долгое время ускользало от научного описания: субъективность, мотивацию, внимание, внутренний опыт. Потому что человеческое сознание — ровно такой же «черный ящик», над вскрытием которого ученые бьются не одну сотню лет.

И пока ИИ остается лишь тенью сознания — пусть точной, мощной, предельно быстрой, но не способной отделить «я» от «мира», — возможно, нам удастся очередная попытка осмыслить, что же значит быть человеком.