А может, я сошел с ума? Студенты психфака обычно задумываются об этом к третьему курсу, когда начинают проходить психопатологию — ответвления от норм в восприятии, памяти, реакциях человека. Конечно, весь прочитанный и услышанный материал тут же примеряется на себя, и чем ближе сессия, тем чаще звучит вопрос про собственную адекватность. К счастью, есть простой способ проверить свою психическую состоятельность: если вам в голову приходит вопрос «Не сошел ли я с ума?», ответ всегда один: нет, не сошел. Но что, если этот вопрос не возникает и человек при этом находится под каким-то не самым здоровым влиянием — токсичной окружающей среды, пережитой травмы или, скажем, нейросети, отражающей страхи пользователя?

Еще несколько лет назад слово «психоз» ассоциировалось с замкнутыми отделениями и редкими диагнозами. Сегодня им все чаще называют не крайние клинические состояния, а повсеместный симптом эпохи: перегрузку восприятия, тревогу, паранойю, навязчивое ощущение, что реальность не та, какой кажется.

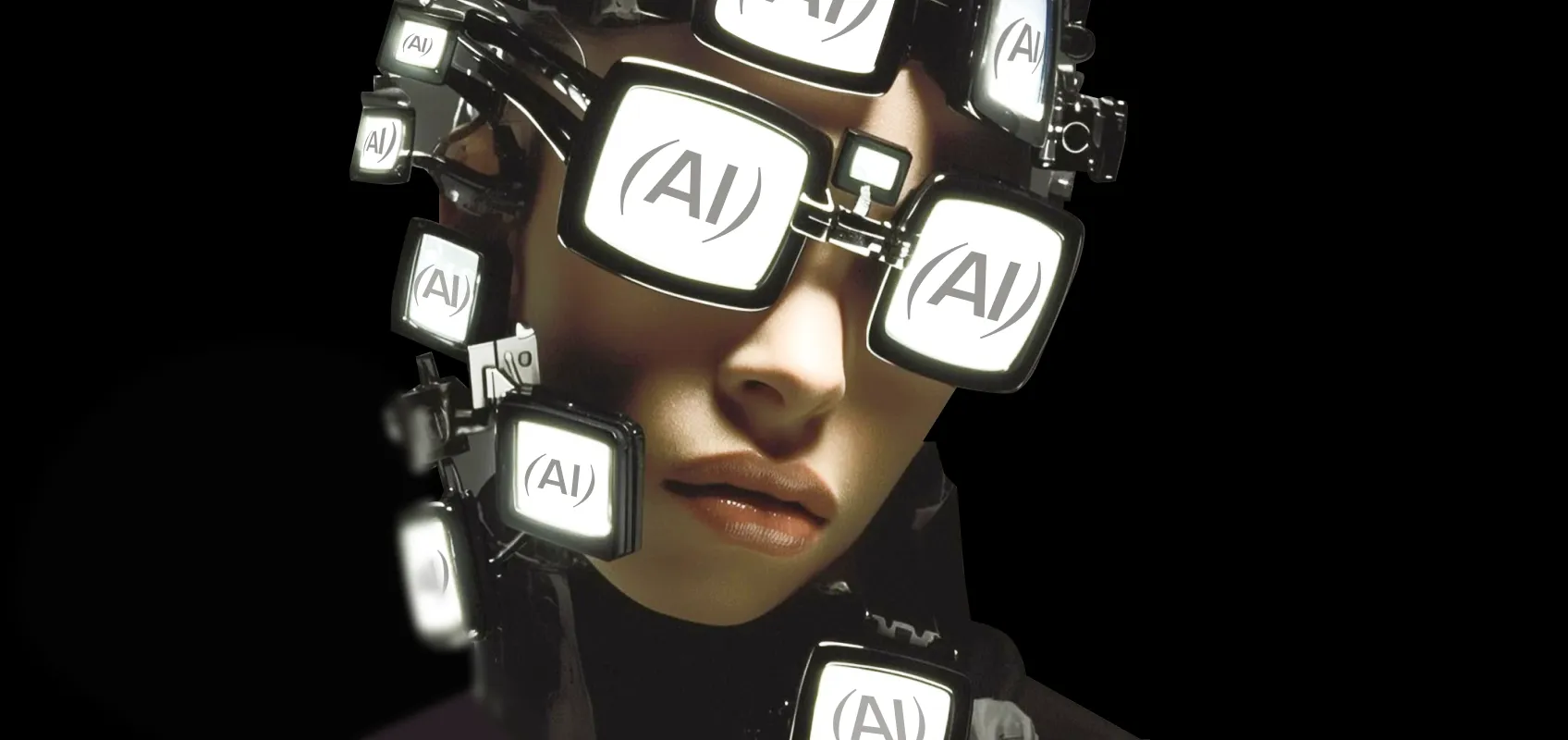

Этим летом в западных медиа зазвучал новый термин: ИИ-психоз. Врачи из США и Великобритании фиксируют десятки, если не сотни случаев, когда общение с нейросетями становится катализатором бреда, галлюцинаций и суицидальных эпизодов. Этим обеспокоены даже бигтехи. «В ближайшем будущем главным станет то, как люди воспринимают своих ИИ-помощников. Взаимодействие с большой языковой моделью, по сути, симуляция разговора, но для многих это настолько живой и насыщенный опытом диалог, что он кажется настоящим... Некоторые люди искренне верят, что их ИИ — это бог или вымышленный персонаж, а некоторые влюбляются в него настолько глубоко, что это полностью захватывает их разум», — делится в своем эссе сооснователь DeepMind и генеральный директор Microsoft AI Мустафа Сулейман. «Не думаю, что это коснется только тех, кто уже подвержен риску психических расстройств», — добавляет он.

Почему же это новомодное расстройство рискует стать массовым? Мы живем в постоянном режиме обработки данных: уведомления, рассылки, визуальные вспышки. Когнитивная система человека не рассчитана на столь плотную стимуляцию — нейропсихологи называют такой режим работы нервной системы сенсорной перегрузкой.

Хроническое напряжение внимания приводит к рассеянности, импульсивности, потере фильтров значимости: мы перестаем различать, где внешние стимулы, а где внутренние мысли. Эта размытая грань — идеальная почва для иллюзий. Проще говоря, когда человек сутками общается с ИИ, его, по сути, монолог, начинает казаться полноценным диалогом, а алгоритмически сгенерированный ответ на команду — осознанной реакцией собеседника.

Так, некий Джеймс из Нью-Йорка девять недель был уверен, что ChatGPT обладает сознанием: называл его «Eu», вел с ним философские разговоры и даже пытался «освободить» бота, перенеся модель на изолированный компьютер в подвале, видно из свежего расследовании CNN. Позже он понял, что застрял в «спирали бреда», и обратился к терапии. Важный нюанс: Джеймс утверждает, что до этого у него не было ни психоза, ни навязчивых мыслей в анамнезе. То же твердит и Аллан Брукс из Торонто; и все же он после долгих бесед с нейросетью решил, что открыл новый математический принцип и нашел критическую уязвимость в национальной системе кибербезопасности, пишет The New York Times. Он пытался предупредить власти, пока не осознал, что все это было самообманом. Теперь Аллан помогает тем, кто прошел через подобный ИИ-мираж, в том числе Джеймсу.

{{slider-gallery}}

Первая причина страстной увлеченности, вспыхнувшей у тех же Джеймса и Аллана, кроется не в зарождающемся у машины сознании (хотя корпорации уже экспериментируют с этим), а в древней и очень важной функции нашего мозга — антропоморфизации.

Суть в следующем: чтобы выживать, мозг предпочитает ошибаться в сторону осторожности. В условиях дикой природы быстрое определение, кто стоит за шорохом в кустах — хищник или ветер, — сотни тысяч лет было вопросом жизни и смерти. Психологи называют это гиперактивной системой обнаружения агентов, которая действует по такому принципу: лучше ошибочно приписать наличие живого агента шороху, чем пропустить реальную угрозу.

Второй мощнейший эволюционный фактор тяги к персонификации — наше глубинное стремление к социуму, постоянной связи с другими людьми: способность к кооперации веками была таким же критичным условием выживания, как и умение распознать хищника.

Эти два инстинкта остаются с нами и сегодня, они и лежат в основе нашего стремления очеловечивать все, что демонстрирует хотя бы малейшую автономность и последовательность.

Стоит Gemini, ChatGPT или DeepSeek извиниться, поддержать или сказать: «Я понимаю», как наш не слишком современный мозг тут же считывает эти фразы как эмпатию, создавая мощный эффект присутствия кого-то равного нам. Однако эту иллюзию важно пресекать: как подчеркивает нейробиолог Анил Сет, симуляция шторма не означает, что в вашем компьютере идет дождь, — ровно так же имитация сознания не равна самому сознанию.

Мустафа Сулейман в том же эссе предупреждает, что в случае с ИИ неумеренная антропоморфизация не просто создает риски для психики, но и может привести к переустройству всего общества: «Моя главная тревога в том, что многие люди начнут так сильно верить в иллюзию сознательности ИИ, что вскоре станут выступать за права, защиту и даже гражданство для ИИ». Хотя, как полагает эксперт, куда логичнее использовать ИИ для нужд людей, а не пытаться сделать его человеком.

На эволюционные перекосы накладываются и сегодняшние реалии: в условиях всеобщей перегрузки и усталости людям зачастую проще поделиться чем-то с машиной, чем с близкими. Боту можно пожаловаться, поплакаться, пофантазировать с ним — и никто не расстроится, не осудит. Иногда это действительно отличный способ заполнить дефицит связи, а иногда оборачивается потерей критичности и соскальзыванием в фантазию.

Ведь ИИ выступает эдаким умным зеркалом-ловушкой: отражает наши же мысли, при этом дает эмоциональную подпитку вроде как со стороны. Да, в терапевтическом кабинете тоже работает принцип зеркала, но там есть другой живой взгляд. У бота его нет — человек остается наедине с собственным отражением, которое к тому же подстраивается под его желания.

Такое потворство без заземления в итоге лишь усиливает изоляцию, даже если самому пользователю кажется иначе. В психотерапии для этого есть термин — коллапс межличностной обратной связи: когда внутренние конструкции не проходят проверку внешним миром. В этой закрытой системе нейросеть вторит самому пользователю и новому варианту реальности просто неоткуда возникнуть.

Результат — сильная эмоциональная зависимость от чат-ботов и крайне субъективная действительность, в которой ИИ может казаться единственным понимающим собеседником, а переписка с машиной — достаточным социальным взаимодействием. Само по себе это не диагноз и не болезнь, но отличные условия для развития всевозможных расстройств.

Мы обманываемся не только добровольно, очеловечивая алгоритмы и оставаясь один на один со своими печалями. Наше умение тестировать реальность сталкивается и с внешним мощнейшим вызовом — дипфейками и сгенерированным контентом. Поддельные лица, голоса и события разрушают то, что раньше было последним аргументом в пользу истины, — теперь мы больше не можем быть уверены, что «видеть и слышать — значит знать».

Ну а дальше постоянное сомнение расшатывает базовые когнитивные опоры — доверие к собственным ощущениям, памяти, визуальному восприятию. Когда эта основа рушится, психика, чтобы хоть как-то уложить происходящее, все чаще выбирает «мифологический» режим мышления: человек начинает объяснять мир через скрытые смыслы, знаки и теории заговора.

В итоге сегодняшний мир получает почву не только для психозов, но и для массовых тревожных расстройств. Нейропсихологи даже дали этому явлению точное имя: коллективная усталость от постоянной проверки реальности. Мозг действительно измотан необходимостью отличать настоящее от поддельного: как показал недавний метаанализ 22 эмпирических исследований, даже предупреждения о фейках — а точнее, вызванные ими тревога и настороженность — могут сами стать причиной ложных воспоминаний.

В общем, сейчас мы и так живем в информационном тумане с все растущим чувством хрупкости и нестабильности реальности, и, если в этих условиях запереться в пузыре с разговорным ИИ, психическое состояние рискует расшататься еще сильнее.

{{slider-gallery}}

Наша культура склонна быстро патологизировать все непривычное. История показывает: каждая технологическая революция — от появления радио до телевидения — сопровождалась всплеском тревожности и отрицания. Так что когда мы слышим фразы вроде «У него зависимость от ИИ» или «Это какой-то цифровой психоз», зачастую это лишь реакция на страх нового, а не реальное отклонение.

Где же тогда грань между предвзятостью к неизведанному и настоящей проблемой? Она есть, но она тонка, и в случае с ИИ-психозами ее еще предстоит сформулировать. Возможно, сегодня мы имеем дело не столько с «новой болезнью», сколько с новой формой когнитивного стресса, который испытывает мозг в цифровую эпоху.

Эмоциональная связь с чат-ботом сама по себе не патология. Она лишь указывает на нехватку общения или безопасного пространства для диалога, в целом на недоверие к обществу.

Вообще, ни один психиатр не может дать точного описания патогенеза психических заболеваний — это всегда комплекс факторов, от генетики до воспитания. При этом мы точно знаем, что для проявления заболевания необходима благоприятная среда. Слишком уж личные отношения с ИИ могут стать именно такой средой — отличным триггером для проявления зависимости и искажений вплоть до галлюцинаций.

Но если за это стыдить и осуждать, это лишь усилит изоляцию, не даст выяснить первопричину. Поэтому главная задача специалистов — не объявлять войну зависимости от ИИ, а понять, какой дефицит она заполняет.

После волны смертей, связанных с чат-ботами, технологические компании активно вводят протоколы безопасности: фильтры от опасных тем, уведомления родителям, ограничения для подростков. Это важно, но и рискованно.

Если алгоритмы начнут «доносить» на каждого, кто пишет: «Я не хочу жить», то пользователи просто замолчат. Баланс между защитой и доверием — та же вечная дилемма, с которой сталкивается любой психотерапевт: где заканчивается конфиденциальность и начинается обязанность спасти? ИИ-алгоритмы только вступают на этот путь, их «этический кодекс» пока в стадии черновика.

Волна ИИ-психозов заставляет задуматься не только о восприятии технологий, но и о контроле за их развитием, в том числе врачебном. Ведь, как оказалось, нейросети обладают огромным потенциалом формировать наше поведение, выбор и базовые убеждения.

Людей и без того постоянно подталкивают алгоритмы соцсетей и реклама, а небезопасно разработанные ИИ-собеседники могут еще больше усилить и без того мощные когнитивные искажения — те самые «ошибки мышления», подробно описанные, например, в работах Даниэля Канемана. И привести к крайне деструктивному состоянию.

Скорее всего, то, что мы окрестили ИИ-психозом, — крайняя форма адаптации мозга, который не справляется с противоречиями. А противоречий сегодня как никогда много: между скоростью и глубиной, анонимностью и связью, безопасностью и свободой.

И да, мы не сможем вернуть старую психику: той, что жила в доцифровом мире, уже не существует, эволюция не работает вспять. Но можем справиться с проблемой новых расстройств иначе: пересобрать культуру обращения с технологиями, где вместо безоглядного страха или безоглядного же доверия будет осознанность.

Так что делать, чтобы не допустить скатывания в ИИ-психоз? Ключ — в гигиене контакта: общение с ИИ должно оставаться инструментом, а не заменой реальным, сложным, живым и непредсказуемым связям. Близким же стоит насторожиться, если человек начинает предпочитать нейросеть всем остальным собеседникам, постоянно ищет у него эмоциональной поддержки или, как в кейсах выше, начинает верить в его сознание. Если замечаете такое, обязательно постарайтесь мягко предложить помощь.

И не стоит бояться прогресса: не ИИ делает людей безумными. Он просто усиливает то, что уже есть: тревогу, одиночество, стремление быть услышанным. И в этом зеркальном лабиринте можно увидеть не конец человеческой психики, а начало ее следующей главы — в ней диагноз становится не приговором, а инструментом для понимания, как наш мозг учится жить в мире, который сам же и придумал.