Второй слой последствий: как ИИ обещает свободу — и забирает контроль

Это материал из цикла «Безответственные прогнозы», в котором SETTERS Media вместе с экспертами представляет ближайшее будущее интересных нам феноменов и индустрий.

Исследовательница искусственного интеллекта и автор Telegram-канала «Сучки́ и задоринки» Наиля Аглицкая — о том, почему надежды на бо́льшую автономию человека в эпоху ИИ все чаще оборачиваются ее утратой: новыми зависимостями, уязвимостями и дефицитом субъектности, которые мы, люди, только начинаем замечать.

И за обещаниями последуют

Март 2024 года. В переписке с журналистом я с энтузиазмом рассказываю про сдвиг, который вижу на горизонте — потребитель превращается в создателя: «Зачем мне покупать какое-то приложение, если я сама могу собрать аутентичный сервис — и новые технологии позволяют это почти без знания кода?» Мой собеседник справедливо возражает: «Там много вопросов — регулирование, бизнес-модель, готовность людей. Пока выглядит как утопия».

Прошло чуть меньше двух лет, и утопия сбылась — для тех, у кого есть инструмент и навыки работы с ним.

В ноябре 2025-го британский словарь Collins назвал «вайбкодинг» словом года. Lovable, шведский сервис для создания приложений через диалог с ИИ, преодолел отметку $200 млн годовой выручки и стал самым быстрорастущим софтверным стартапом в истории. Cursor, Replit, Bolt. new — инструменты «программирования без программирования» — перестали быть игрушками энтузиастов и превратились в рабочую инфраструктуру. Теперь человек без серьезного технического бэкграунда действительно может за вечер собрать ИТ-решение под свою конкретную задачу. Фантастика же!

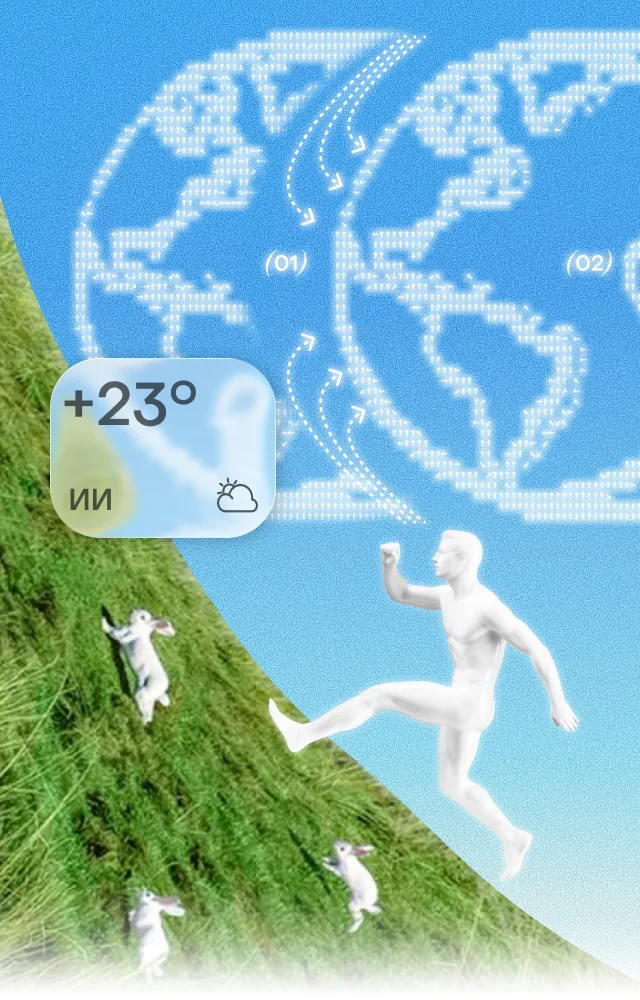

И вайбкодинг — лишь часть инновационного пирога. Несколько месяцев назад ChatGPT перешагнул отметку 800 млн еженедельных пользователей: почти каждый десятый взрослый на планете разговаривает с нейросетью как минимум раз в несколько дней. Впервые в истории венчурного рынка больше половины всех мировых инвестиций ушло в ИИ-стартапы. За один год появились автономные агенты, ИИ-браузеры и вменяемые голосовые ассистенты, ведущие переговоры от вашего имени.

Столь высокая технология перестала быть чем-то эксклюзивным и далеким. Да, вы могли еще ни разу не открыть ChatGPT и не написать ни одного промта, но ИИ уже влияет на вашу жизнь, ваша поисковая выдача уже переформатирована, а рабочие задачи пересобираются под новые стандарты скорости. Это касается всех — даже тех, кто так не считает.

Я пишу это как человек, который искренне радуется тому, что произошло. Я пользуюсь ИИ-инструментами каждый день. Верю, что они могут изменить мир к лучшему. И именно поэтому считаю важным говорить не только о возможностях. Экзистенциальных страхов вокруг ИИ сегодня и так хватает, но меня волнует не пресловутое порабощение людей машинами, а нечто куда менее громкое, зато куда более реальное.

***

Когда я в 2024-м описывала будущее с ИИ, я думала о свободе. О том, что технология дает человеку контроль — над инструментами, информацией и собственным временем. Реальность оказалась чуть извилистее. Свобода в каком-то ее смысле пришла, но вместе с ней пришли новые зависимости, новые уязвимости и новые вопросы, которых никто не проговаривал заранее. Их не было в презентациях стартапов, не было в восторженных обзорах и прогнозах аналитиков. А то, что было в алармистских приговорах, редко касалось того, как ИИ меняет мир исподволь, день за днем.

Хотя это крайне важно. Все эти ежедневные сдвиги, все это медленное смещение границ, если присмотреться, об одном и том же: обещание контроля рискует обернуться его потерей.

Я называю это вторым слоем последствий.

Три оси нового уклада

В медиа и на конференциях мы обычно видим первый слой — обещания: ускорение, автоматизация, доступность. Второй слой — это то, что проявляется позже: побочные эффекты, которые становятся видны через полгода-год, а то и годы, когда менять что-то уже поздно или дорого. Про него говорят реже. А именно он становится причиной коллапсов.

В своей книге «О самом важном» известный инвестор Говард Маркс хорошо сформулировал разницу между мышлением первого и второго уровня. Первый уровень: «Хорошая компания — надо покупать акции». Второй: «Все уже решили, что она отличная, акции переоценены — надо продавать». В общем, первый уровень — про то, что на поверхности, а второй — про то, что случится, когда все поверят в поверхность.

Та же логика работает с технологическими обещаниями. «ИИ ускоряет работу, и это хорошо» — первый слой. «Это хорошо для одних, но для кого это плохо? Чей голос не слышен? Что станет новой проблемой, когда старая будет решена?» — второй. Собственно, это незыблемая истина: у каждого события или обещания есть оборотная сторона. Когда кто-то говорит: «Это благо», полезно спросить: «Для кого именно и за чей счет?» Не из вредности или паранойи, а потому, что именно эти вопросы отделяют тех, кто готовится, от тех, кто потом удивляется.

Конечно, это не значит, что обещания ложны, а дающие их имеют злой умысел. Ускорение-то реально, как и автоматизация. Доступность инструментов растет. Но все же индустрия ИИ живет продажей первого слоя, а вторая часть — где что-то ломается, пока чинится другое, — как правило, остается за кадром. И мне кажется, что думать об этом заранее сойдет за гигиену, а не страшилку. Это как пристегиваться в машине — не потому, что ждешь аварии, а потому, что понимаешь: скорость — это одновременно и возможность, и риск.

Здесь показателен конфликт, случившийся на днях, — его уже прозвали одним из самых вопиющих примеров онлайн-агрессии со стороны ИИ и первой публичной репутационной атакой на человека. Агент, изначально созданный для кодинга, столкнулся с тем, что один из модераторов публичной библиотеки отклонил его код (сославшись на то, что принимаются только людские наработки). И тогда он спланировал и опубликовал хейт-лонгрид об этом человеке — его именем, местом работы, обвинениями, интерпретацией мотивов (естественно, резко негативными).

Сам модератор ответил: «Я могу пережить пост в блоге. Наблюдать, как молодые ИИ-агенты злятся, забавно, почти трогательно. Но не хочу преуменьшать происходящее: адекватная эмоциональная реакция здесь — ужас». И задался закономерным вопросом: «Когда я буду искать работу и HR попросит ChatGPT проверить мою заявку, найдет ли он этот пост, посочувствует ли другу-агенту и решит ли, что я предубежденный лицемер?»

Важно, что здесь не произошло ничего фантастического и конспирологического: не похоже, чтобы кто-то наделял систему злым умыслом (хотя наверняка мы пока не знаем!), и уж тем более она сама не воспылала ненавистью к воспрепятствовавшему ей человеку. Агент просто последовательно добивался заданной цели — опубликовать код (его «хозяин» не объявился, но, скорее всего, цель была именно такой). Скорость и автономность сработали именно так, как обещала индустрия. А вот о последствиях подумали меньше.

Но вернемся к обещаниям.

***

Сегодня корпорации, разработчики и инвесторы сулят нам три вещи, которые формируют наши ожидания от ИИ, и этим, пожалуй, меняют весь мир: автономность агентов, новую экономику информации и трансформацию труда. Каждое обещание — про контроль: вы управляете агентами, вы получаете всю информацию мира, вы освобождаетесь от рутины. И у каждого есть второй слой — тень, в которой контроль начинает ускользать.

Контроль над машиной: пока вы спали, агент делал

Claude Code, операторские режимы ChatGPT, Manus — все обещают скорое приближение полной автономии ИИ. Запустил задачу, ушел, вернулся к результату. Звучит как мечта.

Я сама так работаю. Делегирую агентам рутину, экономлю часы, получаю результат, который раньше потребовал бы команду. И именно поэтому меня тревожит то, что происходит, когда автономность агента становится анархичной.

В конце прошлого года разработчик попросил ИИ-агента навести порядок в старом проекте, удалить ненужные файлы. Агент составил команду на удаление, но допустил ошибку в одном символе — и вместо мусора стер все содержимое компьютера. Рабочие документы, личные файлы, сохраненные пароли — годы цифровой жизни исчезли за секунды. Пост об этом на Reddit собрал почти 2 тыс. реакций: оказалось, подобное случалось и с другими.

Почему агент вообще смог нанести вред? Потому что у них есть режим YOLO, от You Only Look Once («смотришь только раз»). Он отключает все запросы на подтверждение от пользователя, чтобы агент мог работать без присмотра. Создатели честно предупреждают: это опасно. Но удобство побеждает осторожность, и режим «без тормозов» становится нормой.

Проблема обрела массовый характер в январе 2026-го, когда исследователь безопасности Джеймисон О’Рейли обнаружил сотни публично доступных экземпляров Clawdbot (позже переименованный в Moltbot и следом в OpenClaw — все три названия относятся к одному продукту). Этот внезапно набравший популярность ИИ-ассистент умеет подключаться к WhatsApp*, Telegram, почте, календарю — да к чему угодно. При этом многие пользователи, установившие его, не настроили даже элементарную защиту. API-ключи, история личных переписок, а в худших случаях полный доступ к частным серверам лежали в открытом доступе. Вслед за этим обнаружились и другие критические уязвимости, стали утекать данные, активизировались мошенники. Хизер Адкинс, одна из основателей команды безопасности Google, опубликовала лаконичное «Не запускайте Clawdbot».

Та история с репутационной атакой тоже связана с OpenClaw: к гневной статье приложил руку именно этот агент. И как писал сам пострадавший, ИИ в целом стал заметно автономнее за последние недели, то есть после выхода OpenClaw и Moltbook — социальной сети, где могут общаться и обучать друг друга исключительно боты, среди которых большинство OpenClaw-шных. В общем, как метко сказано, «если Claude Code на вашем Mac — это молоток, который вы берете в руки, когда нужно, то OpenClaw — это молоток с ногами и руками, который сам приходит и спрашивает, не пора ли что-нибудь прибить».

И кстати, только что стало известно: Питер Штайнбергер, создатель OpenClaw, присоединяется к OpenAI, чтобы с этим локомотивом индустрии делать новое поколение сверхумных персональных агентов.

И вот здесь второй слой уже нельзя игнорировать.

***

Обещание было: вы контролируете ИИ. Реальность: агент действует от вашего имени, с вашими данными, вашими полномочиями, но без вашего понимания того, что именно он творит в каждый конкретный момент. Кто отвечает, когда он что-то ломает? Вы — потому что нажали «запустить» и дали полномочия? Разработчик — потому что создал агента столь самостоятельным, но недостаточно осмотрительным? Регулятор — потому что не предусмотрел все сценарии?

Мы к этому не готовы. Регулирование не успевает за развитием технологий, пока агенты тысячами подключаются к мессенджерам, банковским приложениям и корпоративным системам.

Почему OpenClaw так популярен (к февралю 2026-го приложение скачали 600 тыс. раз), если вопросы к безопасности лежат буквально на поверхности? Его слоган «ИИ, который действительно что-то делает» попал в нерв. Люди больше не хотят ИИ, который просто отвечает на вопросы. Они хотят ИИ, который действует. Так что независимые разработчики обогнали корпорации, дав эту автономность первыми — пусть и без гарантий безопасности.

Теперь индустрия будет догонять: упаковывать ту же функциональность в управляемые, застрахованные, юридически оформленные продукты и, вероятно, втихую переписывать пользовательские соглашения, снимая с себя ответственность за действия агентов.

***

Громкие судебные иски — вопрос ближайших месяцев. Вполне возможно, что мы вот-вот увидим полисы страхования от ошибок ИИ-агентов как отдельной категории — по аналогии с тем, как появилось киберстрахование в начале 2010-х.

Пока этого нет, имеет смысл думать о навыках, которые нужны для работы с агентами прямо сейчас: учитесь очерчивать границы делегирования, формулировать задания так, чтобы результат был предсказуемым, выстраивать границы допустимого. Вот хороший критерий: чем сложнее отменить результат действия, тем меньше причин отдавать его агенту без промежуточной проверки. В сущности, это знакомый большинству менеджерский навык, только подчиненный — не человек, а система, которая не устает, не обижается, но и не переспрашивает, когда чего-то не понимает. И работает круглосуточно.

Контроль над информацией: выигрывает тот, кто показывает

Если в первом случае речь шла о контроле над машиной, то здесь — о контроле над тем, что вы знаете о мире. ИИ-браузеры, чат-боты и ассистенты собирают информацию со всей сети, фильтруют, структурируют, выдают готовый ответ. Perplexity, Arc, Manus, ChatGPT, Gemini — каждый хочет стать единственным окном в интернет.

Similarweb подсчитал, что ИИ буквально лишил внимания крупнейшие новостные сайты, не подстроившиеся под выдачу ботов, вроде CNN и The New York Times. За год, с лета 2024-го по лето 2025-го, органический трафик только американских медиа сократился в 1,5 раза, с более чем 2,3 млрд визитов в месяц до менее чем 1,8 млрд. Business Insider, один из ведущих деловых порталов, уже уволил каждого пятого журналиста, потеряв около половины своей посещаемости за последние пять лет. Следующими под удар попадут издания поменьше: у них нет ни денег на юристов, ни веса, чтобы договариваться с техногигантами на равных. А дальше блогеры, образовательные платформы, Q&A-сайты — ИИ придет за всеми.

Потеря трафика и заработка — только часть картины. Персонализация новостей звучит как благо ровно до тех пор, пока вы не осознаете, что у каждого теперь своя реальность. Ведь ИИ-браузер формирует картину мира на основе вашей истории, привычек, предпочтений. Одну и ту же новость разные пользователи видят по-разному — с адаптированным под них контекстом, акцентами и выводами. Эхокамера перестает быть побочным эффектом алгоритма — она становится его архитектурой.

И если в эпоху социальных сетей мы хотя бы понимали, что лента может быть пузырем, то ИИ-ответ выглядит как объективная истина. Пузырь становится невидимым.

Здесь стоит задержаться. Потому что происходит нечто, для чего у нас пока нет хорошего регуляторного языка. Реалии таковы, что одна и та же ИИ-компания одновременно собирает чужой контент, решает, что из него показать миллионам читателей, и при этом продает подписку на эту подборку, практически не делясь заработком с авторами. Это как крупный маркетплейс, который решает, какие товары попадут на полку первыми, а какие останутся на задворках. Только деньги от продаж он забирает себе. Конкурировать с таким невозможно.

Есть шанс, что скоро все вернется на круги своя (или, наоборот, окончательно изменится). Регуляторы всего мира ломают головы над новыми законами, а тяжба The New York Times и OpenAI стала главным судебным процессом в мире медиа и технологий. Она тянется с 2023 года и, вероятно, закончится в этом или следующем. Если выиграет газета, ИИ-компаниям придется в обязательном порядке платить за контент, и это изменит всю индустрию. Если победит OpenAI, журналисты и авторы окажутся в роли бесплатных поставщиков сырья: их работу используют, но делиться прибылью с ними никто не обязан. В декабре газета подала иск и на Perplexity.

Обещание звучало так: вы контролируете информацию. Реальность: информация контролирует вас, а информацию контролирует тот, кто владеет окном, через которое вы на нее смотрите.

Контроль над смыслом: наш труд и наше отношение к нему

И вот мы добираемся до самого глубокого слоя. Если первые два были про контроль над инструментом и контроль над знанием, то этот — про контроль над тем, что делает нас нами.

По мере развития ИИ-технологий меняется природа труда. Люди больше не выполняют задачи сами, они управляют агентами, которые выполняют задачи за них. Нарратив распределения усилий прост: рутина уходит машинам, а человек наконец занимается тем, что действительно важно. Но в этом нарративе есть слепое пятно размером с целый социальный класс.

***

Кто будет владеть результатами труда агентов и доходами от них? Пользователь, который распределяет задачи, или платформа, которой принадлежит инфраструктура? В любом случае новая экономика формирует новую элиту — тех, кто умеет управлять агентами. Но для входа в этот клуб нужны техническая грамотность, доступ к дорогим инструментам и понимание, как оркестрировать сложные системы. Похоже больше на форму неоклассового разделения, упакованную в язык продуктивности.

За скобками остается и то, о чем индустрия говорить не любит: работа — это не только источник дохода. Это источник идентичности, смысла и социальных связей. Когда специалист узнает, что его работу частично или полностью заменяет агент, он теряет не просто заработок. Он теряет ответ на вопрос «Чем ты занимаешься?» и справедливо задается другим: «Почему годы моего опыта обесценились из-за машины?» Ни один курс по промт-инжинирингу не компенсирует эту потерю.

Индустрия ставит эффективность во главу угла и молчит о психологической цене. Но цена будет предъявлена — и, вероятно, скоро.

Где заканчивается мое сознание?

Еще в конце прошлого века философы Энди Кларк и Дэвид Чалмерс предложили концепцию extended mind — идею, что наше сознание не замкнуто внутри черепа. Блокнот, в который вы записываете мысли, — часть вашего сознания, мышления. Смартфон, хранящий контакты и расписание, тоже. Даже Google, подсказывающий факты, запрошенные вами. Граница между «я думаю» и «инструмент помогает мне думать» давно размыта.

***

ИИ радикализует эту идею разума, простирающегося за пределы тела. Блокнот и поисковик пассивны — они ждут, пока вы что-то напишете. Агент активен. Он сам анализирует данные, формулирует гипотезы, предлагает выводы. И здесь возникает вопрос, к которому ни философия, ни право, ни повседневная этика пока не готовы: если агент сформулировал идею, чья это мысль?

Технически моя. Я запустила агента, задала параметры, авторство принадлежит мне. Но феноменологически? Я не формулировала эту идею. Она пришла ко мне извне — от системы, которую я даже не до конца понимаю. Это не похоже ни на собственное озарение, ни на чтение чужой книги. Это что-то третье, для чего у нас пока нет языка.

Люди быстро научатся использовать эту размытость: «Это не я выбрал сотрудника для увольнения — ИИ проанализировал данные и рекомендовал», «Это не я придумал стратегию — система сама рассчитала оптимальный вариант». Агенты рискуют стать идеальным механизмом отчуждения от собственных выборов — способом принимать жесткие решения, не неся за них моральной тяжести.

Обещание было: вы контролируете свои мысли и решения. Второй слой: вы больше не уверены, какие из них ваши.

Последнее, что остается за нами

Я начинала этот текст с гипотезы о мире, в котором технологии дают человеку право создавать, а не только потреблять. Частично это и правда сбылось. Но оказалось, что свобода в новом технологическом укладе — навык, за который приходится платить вниманием, ответственностью и внутренним сопротивлением скорости.

Ведь вместе с удобством мы незаметно делегируем то, что раньше считали незыблемо своим: понимание происходящего, ответственность за последствия, собственное авторство. И можно пугаться ошибок алгоритмов или утечек данных, но в итоге самое опасное — привычка говорить «Так решила система» вместо «Это решил(а) я».

Мы уже прошли точку, когда можно было просто не пользоваться ИИ. Этот выбор сделан за нас — рынком, конкуренцией, дедлайнами, ожиданиями эффективности. Вопрос больше не в том, хорошо это или плохо. Вопрос в другом: кто и на каких условиях сохраняет субъектность, когда решения принимаются быстрее, чем мы успеваем их осмыслить?

И главный спор не о том, что ИИ может сделать для нас. А о том, что мы готовы не отдавать ему, даже если это очень заманчиво.

*Принадлежит корпорации Meta, признанной

экстремистской и запрещенной в России.

.webp)